java flink + kafka,后端状态放hdfs后,每次重启服务,又从最早的消息开始消费问题

java flink + kafka,后端状态放hdfs后,每次重启服务,又从最早的消息开始消费,不是每次会提交检查点到hdfs吗,重启后,不应从最新的检查点开始处理么?

[AIGC ~大数据] 深入理解Hadoop、HDFS、Hive和Spark:Java大师的大数据研究之旅

作为一位Java大师,我始终追求着技术的边界,最近我将目光聚焦在大数据领域。在这个充满机遇和挑战的领域中,我深入研究了Hadoop、HDFS、Hive和Spark等关键技术。本篇博客将从"是什么"、"为什么"和"怎么办"三个角度,系统地介绍这些技术。是什么?HadoopHadoop是一个开源的分布式...

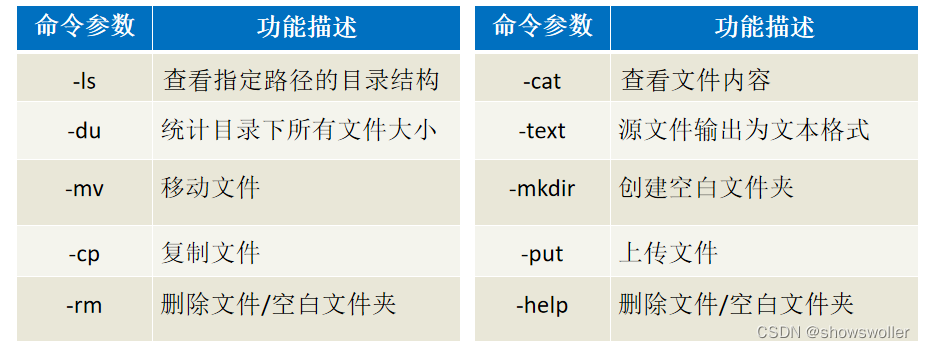

【大数据技术Hadoop+Spark】HDFS Shell常用命令及HDFS Java API详解及实战(超详细 附源码)

需要源码请点赞关注收藏后评论区留言私信~~~一、HDFS的Shell介绍Shell在计算机科学中俗称“壳”,是提供给使用者使用界面的进行与系统交互的软件,通过接收用户输入的命令执行相应的操作,Shell分为图形界面Shell和命令行式Shell。文件系统(FS)Shell包含了各种的类Shell的命...

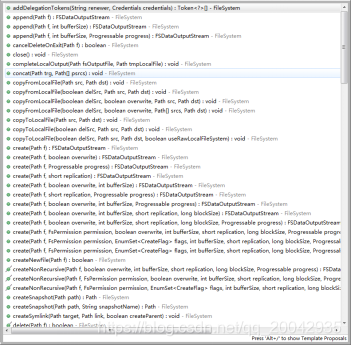

大数据 | Java 操作 HDFS 常用 API

上篇文章介绍了关于 HDFS 的常用命令,其常用的命令都有相应的 API,用命令可以完成的功能,使用 Java API 也可以完成。本文介绍关于 HDFS 常用的 Java API。一、回顾常用的命令 &n...

16 HDFS的java操作

hdfs 在生产应用中主要是客户端的开发,其核心步骤是从hdfs提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件。1.搭建开发环境1.引入依赖<dependency> <groupId>org.apache.hadoop&l...

java api操作HDFS

如果是使用maven的话,导入如下依赖即可,否则需要在解压好的hadoop文件夹下找到common文件夹和hdfs文件夹下的jar包<dependency> <groupId>org.apache.hadoop</groupId> <artifactId&g...

有偿求助,Flink1.15读取hdfs中的parquet文件的Java样例

网上都是1.9版本的,里面用到的ParquetRowInputFormat在下面的依赖中已经没有了! org.apache.flink flink-parquet 1.15.0

hadoop3自学入门笔记(3)-java 操作hdfs

hadoop3自学入门笔记(3)-java 操作hdfs1.core-site.xml<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.3....

HDFS Java API编程

hadoop实验:HDFS Java API编程实验目的:1、理解HDFS Java API编程原理;2、掌握HDFS的命令;3、掌握Elipse远程调试Hadoop程序的方法;4、掌握HDFS基本的API调用方法。实验任务:能够完成eclipse安装及环境搭建能够编写hdfs基本操作代码并打包到l...

E-MapReduce集群-JAVA客户端远程连接HDFS

部署在阿里云的EMR集群,通过公网进行连接,使用HDFS的JAVA-SDK,进行目录树的维护以及文件存储、下载。1. 集群环境a. EMR集群版本阿里云EMR on ECS集群集群版本 EMR-5.9.0集群类型 DataLakeHadoopCommon 3.2.1HDFS 3.2.12. 本地环境...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

文件存储HDFS版java相关内容

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版文件

- 文件存储HDFS版flink

- 文件存储HDFS版parquet

- 文件存储HDFS版设置

- 文件存储HDFS版格式

- 文件存储HDFS版hive

- 文件存储HDFS版映射

- 文件存储HDFS版cdc

- 文件存储HDFS版javaapi

- 文件存储HDFS版测试

- 文件存储HDFS版hadoop

- 文件存储HDFS版数据

- 文件存储HDFS版大数据

- 文件存储HDFS版操作

- 文件存储HDFS版api

- 文件存储HDFS版命令

- 文件存储HDFS版集群

- 文件存储HDFS版存储

- 文件存储HDFS版文件存储

- 文件存储HDFS版配置

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版架构

- 文件存储HDFS版读取

- 文件存储HDFS版namenode

- 文件存储HDFS版mapreduce