使用Scrapy框架抓取小红书上的#杭州亚运会#相关内容

杭州亚运会作为一项重要的国际体育盛事,吸引了全球的关注。在亚运会期间,人们对于相关新闻、赛事、选手等信息都表现出了浓厚的兴趣。而小红书作为一个以分享生活和购物为主题的社交平台,也有大量关于#杭州亚运会#的用户笔记,文将介绍如何使用Python的Scrapy框架来抓取小红书上的经验与#杭州亚运会#相关...

如何使用Scrapy框架抓取电影数据

随着互联网的普及和电影市场的繁荣,越来越多的人开始关注电影排行榜和评分,了解电影的排行榜和评分可以帮助我们更好地了解观众的喜好和市场趋势.豆瓣电影是一个广受欢迎的电影评分和评论网站,它提供了丰富的电影信息和用户评价。因此,爬取豆瓣电影排行榜的数据对于电影从业者和电影爱好者来说都具有重要意义。我们的目...

使用 Scrapy 建立一个网站抓取器

Scrapy 是一个用于爬行网站以及在数据挖掘、信息处理和历史档案等大量应用范围内抽取结构化数据的应用程序框架,广泛用于工业。在本文中我们将建立一个从 Hacker News 爬取数据的爬虫,并将数据按我们的要求存储在数据库中。安装我们将需要 Scrapy以及 BeautifulSoup用于屏幕抓取...

想问一个关于用scrapy进行抓取,用redis存储所抓取数据的id进行去重的问题

为什么会出现数据库新增10条数据,但是redis却只写入了一个id这种现象啊。数据库写入的数据没有重复。 本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。 https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

20、 Python快速开发分布式搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

编写spiders爬虫文件循环抓取内容 Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数, 参数: url='url' callback=页面处理函数 使用时需要yield Request() parse.urljoin()方法,是urllib库下的方法,是自动u...

Python爬虫入门教程 40-100 博客园Python相关40W博客抓取 scrapy

爬前叨叨 第40篇博客吹响号角,爬取博客园博客~本文最终抓取到了从2010年1月1日到2019年1月7日的37W+文章,后面可以分析好多东西了呢 经常看博客的同志知道,博客园每个栏目下面有200页,多了的数据他就不显示了,最多显示4000篇博客如何尽可能多的得到博客数据,是这篇文章研究的一点点核心内...

使用scrapy抓取股票代码

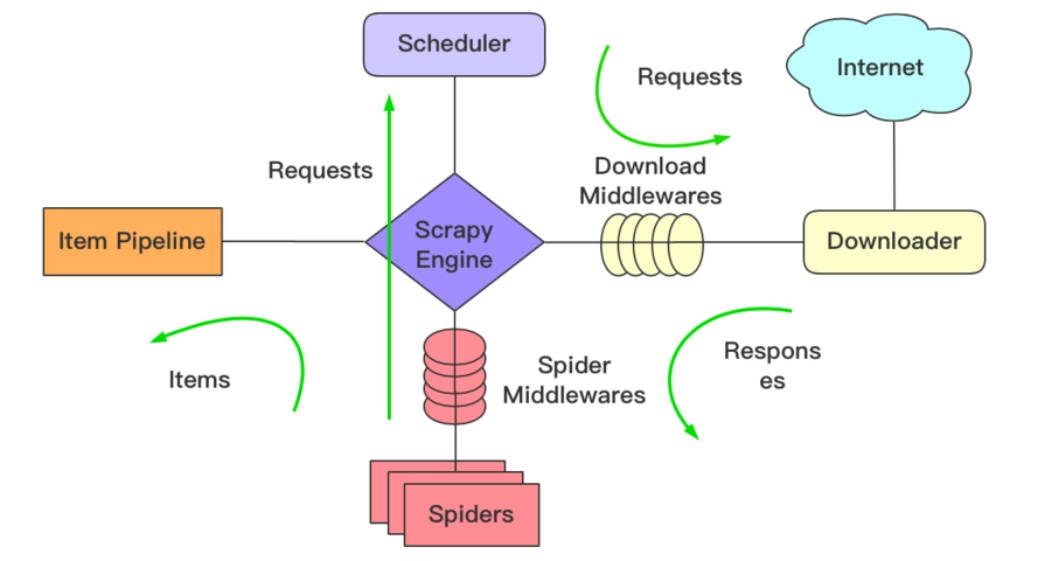

个人博客:https://mypython.me 源码地址:https://github.com/geeeeeeeek/scrapy_stock 抓取工具:scrapy scrapy介绍 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 可以应用在包括数据挖掘,信息处理或存储历史...

爬虫进阶:Scrapy抓取科技平台Zealer

开篇 这次的目标网站也是本人一直以来有在关注的科技平台:Zealer,爬取的信息包括全部的科技资讯以及相应的评论。默认配置下运行,大概跑了半个多小时,最终抓取了5000+的资讯以及10几万的评论。 Zealer Media 说明及准备 开发环境:Scrapy、Redis、PostgreSQL...

爬虫进阶:Scrapy抓取慕课网

前言 Scrapy抓取慕课网免费以及实战课程信息,相关环境列举如下: scrapy v1.5.1 redis psycopg2 (操作并保存数据到PostgreSQL) 数据表 完整的爬虫流程大致是这样的:分析页面结构 -> 确定提取信息 -> 设计相应表结构 -> 编写爬...

Python爬虫框架scrapy抓取旅行家网所有游记!从此出游不发愁!

Scrapy是一个用 Python 写的 Crawler Framework ,简单轻巧,并且非常方便。Scrapy 使用 Twisted 这个异步网络库来处理网络通讯,架构清晰,并且包含了各种中间件接口,可以灵活的完成各种需求。 以上是网上摘录的一段介绍scrapy框架的文字,大过年的,懒癌高发期...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子