![深度学习基础入门篇[三]:优化策略梯度下降算法:SGD、MBGD、Momentum、Adam、AdamW](https://ucc.alicdn.com/pic/developer-ecology/fnj5anauszhew_f511d389031a4c4bad8dee88a9c27c42.jpeg)

深度学习基础入门篇[三]:优化策略梯度下降算法:SGD、MBGD、Momentum、Adam、AdamW

深度学习基础入门篇[三]:优化策略梯度下降算法:SGD、MBGD、Momentum、Adam、AdamW1.梯度下降算法(优化器)1.1 原理解释如果我们定义了一个机器学习模型,比如一个三层的神经网络,那么就需要使得这个模型能够尽可能拟合所提供的训练数据。但是我们如何评价模型对于数据的拟合是否足够呢...

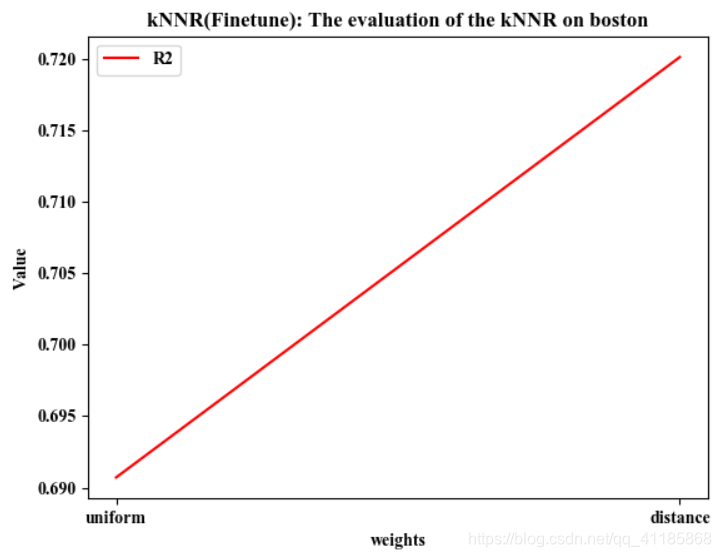

ML之回归预测:利用十类机器学习算法(线性回归、kNN、SVM、决策树、随机森林、极端随机树、SGD、提升树、LightGBM、XGBoost)对波士顿数据集回归预测(模型评估、推理并导到csv)

目录利用十类机器学习算法(线性回归、kNN、SVM、决策树、随机森林、极端随机树、SGD、提升树、LightGBM、XGBoost)对波士顿数据集【13+1,506】回归预测(模型评估、推理并导到csv)输出数据集1、LiR 线性回归算法2、kNNR k最近邻算法3、SVMR 支持向量机算法4、DT...

TF之NN:利用DNN算法(SGD+softmax+cross_entropy)对mnist手写数字图片识别训练集(TF自带函数下载)实现87.4%识别

输出结果代码设计import numpy as npimport tensorflow as tfimport matplotlib.pyplot as pltfrom tensorflow.examples.tutorials.mnist import input_dataprint ("pack...

DL之DNN优化技术:神经网络算法简介之GD/SGD算法的简介、代码实现、代码调参之详细攻略(二)

GD算法的改进算法1、SGD算法(1)、mini-batch如果不是每拿到一个样本即更改梯度,而是若干个样本的平均梯度作为更新方向,则是mini-batch梯度下降算法。(1)、SGD与学习率、Rate、LossGD算法中的超参数1、学习率(1)、固定学习率实验的C代码(2)、回溯线性搜索(Back...

DL之DNN优化技术:神经网络算法简介之GD/SGD算法的简介、代码实现、代码调参之详细攻略(一)

目录GD算法的简介GD/SGD算法的代码实现1、Matlab编程实现GD算法的改进算法GD算法中的超参数GD算法的简介 GD算法,是求解非线性无约束优化问题的基本方法,最小化损失函数的一种常用的一阶优化方法。如图所示,找出最陡峭的方向作为下山的方向。1、如何求...

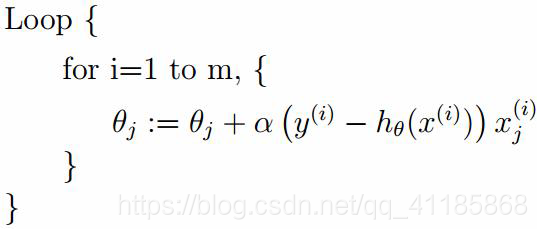

11 回归算法 - BGD、SGD、MBGD梯度下降

=== 名词解释 === BGD: 批量 - 梯度下降算法 SGD: 随机 - 梯度下降算法 __MBGD:__小批量 - 梯度下降算法 === 批量梯度下降算法 BGD === 在上一章10 回归算法 - 梯度下降中讲述的梯度下降算法是针对某一个样本进行的。实际上,我们拥有m个样本,针对每一个样本...

深度学习笔记6:神经网络优化算法之从SGD到Adam

1 从前面的学习中,笔者带大家一起学会了如何手动搭建神经网络,以及神经网络的正则化等实用层面的内容。这些都使得我们能够更深入的理解神经网络的机制,而并不是初次接触深度学习就上手框架,虽然对外宣称神经网络是个黑箱机制,但是作为学习者我们极度有必要搞清楚算法在每个环节到底都干了些什么。 今天笔者需要讲的...

从动力学角度看优化算法SGD:一些小启示

在本文中,我们来关心优化算法 SGD(stochastic gradient descent,随机梯度下降),包括带 Momentum 和 Nesterov 版本的。对于 SGD,我们通常会关心的几个问题是: SGD 为什么有效? SGD 的 batch size 是不是越大越好? SGD 的学习率...

2017年深度学习优化算法最新进展:如何改进SGD和Adam方法?

本文来自AI新媒体量子位(QbitAI) 深度学习的基本目标,就是寻找一个泛化能力强的最小值,模型的快速性和可靠性也是一个加分点。 随机梯度下降(SGD)方法是1951年由Robbins和Monro提出的[1],至今已有60年历史。在当前的深度学习研究中,这种方法至关重要,一般被用在反向传播过程中。...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。