文本分类还停留在BERT?对偶比学习框架也太强了

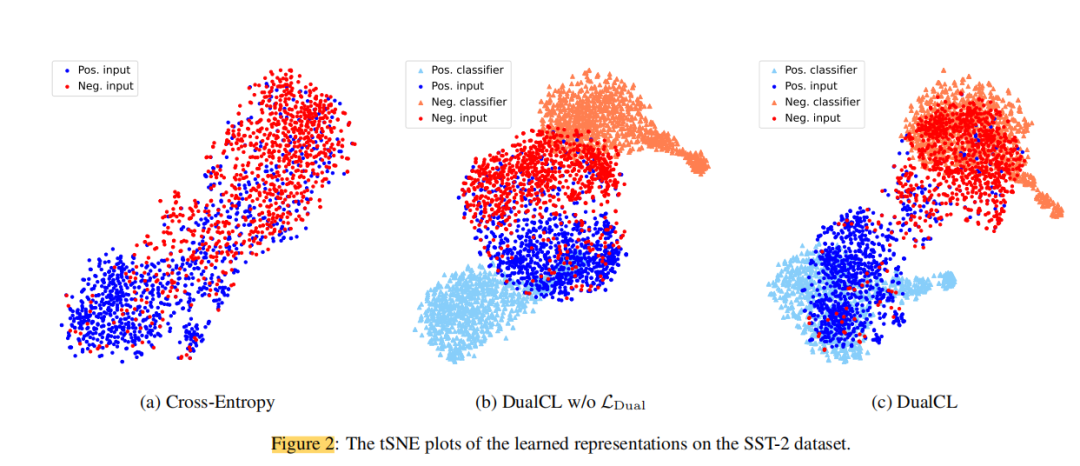

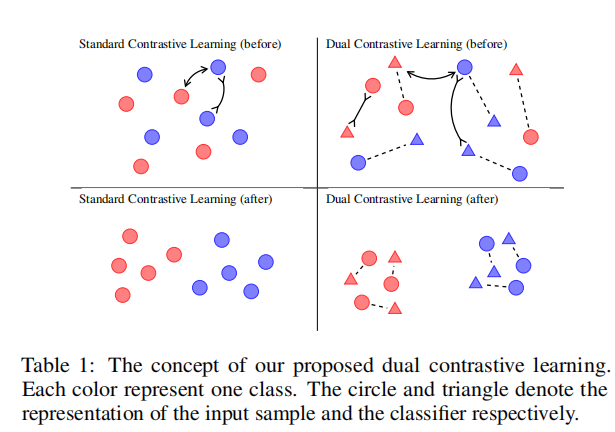

论文摘要对比学习在无监督环境下通过自我监督进行表征学习方面取得了显著的成功。然而,有效地使对比学习适应于监督学习任务在实践中仍然是一个挑战。在这项工作中,作者提出了一个对偶对比学习(DualCL)框架,在同一空间内同时学习输入样本的特征和分类器的参数。具体来说,DualCL将分类器的参数视为关联到不...

文本分类还停留在BERT?对偶对比学习框架也太强了(二)

实验结果从结果中可以看出,除了使用RoBERTa的TREC数据集外,同时使用BERT和RoBERTa编码器在几乎所有设置中都取得了最好的分类性能。与具有完整训练数据的CE+CL相比,DualCL对BERT和RoBERTa的平均改善率分别为0.46%和0.39%。此外,我们观察到,在10%的训练数据下...

文本分类还停留在BERT?对偶对比学习框架也太强了(一)

论文简介:对偶对比学习:如何将对比学习用于有监督文本分类论文标题:Dual Contrastive Learning: Text Classification via Label-Aware Data Augmentation论文链接:https://arxiv.org/pdf/1905.09788...

LRC-BERT:对比学习潜在语义知识蒸馏|AAAI 2021

【新智元导读】高德智能技术中心研发团队在工作中设计了对比学习框架进行知识蒸馏,并在此基础上提出COS-NCE LOSS,该论文已被AAAI2021接收。NLP自然语言处理在高德各个业务线发挥重要作用,例如动态事件命名实时识别,搜索场景用户语义理解,共享出行通话文本自动判责等。而NLP领域近期最重要的...

最强NLP模型BERT可视化学习

2018年是自然语言处理(Natural Language Processing, NLP)领域的转折点,一系列深度学习模型在智能问答及情感分类等NLP任务中均取得了最先进的成果。近期,谷歌提出了BERT模型,在各种任务上表现卓越,有人称其为“一个解决所有问题的模型”。 BERT模型的核心思想有两点...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。