预训练语言模型中Transfomer模型、自监督学习、BERT模型概述(图文解释)

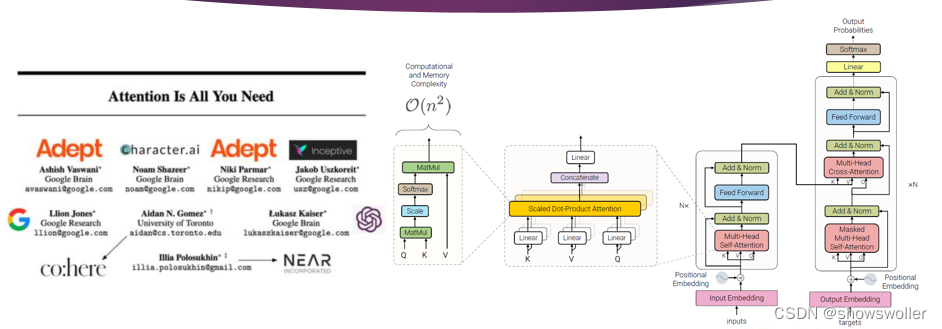

一、Transformer变换器模型Transformer模型的编码器是由6个完全相同的层堆叠而成,每一层有两个子层 。第一个子层是多头自注意力机制层,第二个子层是由一一个简单的、按逐个位置进行全连接的前馈神经网络。在两个子层之间通过残差网络结构进行连接,后接一一个层正则化层。可以得出,每一一个子层...

BERT模型基本理念、工作原理、配置讲解(图文解释)

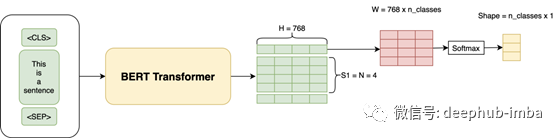

一、BERT的基本理念BERT是Birdirectional Encoder Representation from Transformers的缩写,意为多Transformer的双向编码器表示法,它是由谷歌发布的先进的嵌入模型,BERT是自然语言处理领域的一个重大突破,它在许多自然语言处理任务中取...

【BERT-多标签文本分类实战】之二——BERT的地位与名词术语解释

·请参考本系列目录:【BERT-多标签文本分类实战】之一——实战项目总览·下载本实战项目资源:>=点击此处=<【注】本篇将从宏观上介绍bert的产生和在众多模型中的地位,以及与bert有关的许多名词。[1] bert的提出 Bert模型是Google在2018年10月发布的语言表示模型...

图解BERT:通俗的解释BERT是如何工作的

谷歌2018年发布的BERT是NLP最有影响力的论文之一。在本文中,我将进一步介绍BERT,这是最流行的NLP模型之一,它以Transformer为核心,并且在许多NLP任务(包括分类,问题回答和NER)上均达到了最先进的性能。具体地说,与其他关于同一主题的文章不同,我将...

用于自然语言处理的BERT-双向Transformers的直观解释

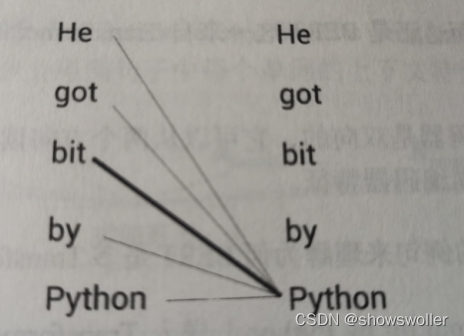

在这篇文章中,我们将使用一种直观的方法来理解NLP的发展,包括BERT。预训练策略使BERT如此强大和流行,并且BERT可针对大多数NLP任务进行微调。自然语言处理(NLP)算法的发展考虑一下如果你想学习一门新的语言,印地语。而且你很懂英语。首先是要在已知语言的上下文中理解新语言中每个单词的含义。您...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。