《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践

作者:金风 用户背景 小米科技有限责任公司成立于2010年3月3日,是一家专注于智能硬件和电子产品研发的全球化移动互联网企业,同时也是一家专注于智能手机、互联网电视及智能家居生态链建设的创新型科技企业。 小米公司创造了用互联网模式开发手机操作系统、发烧友参与开发改进的模式。 业务...

《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践(2)

《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践(1) https://developer.aliyun.com/article/12284723、作业调度 小米在作业调度方面也做了一些尝试。如上图左边这段 SQL,在离线调度模式...

《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践(3)

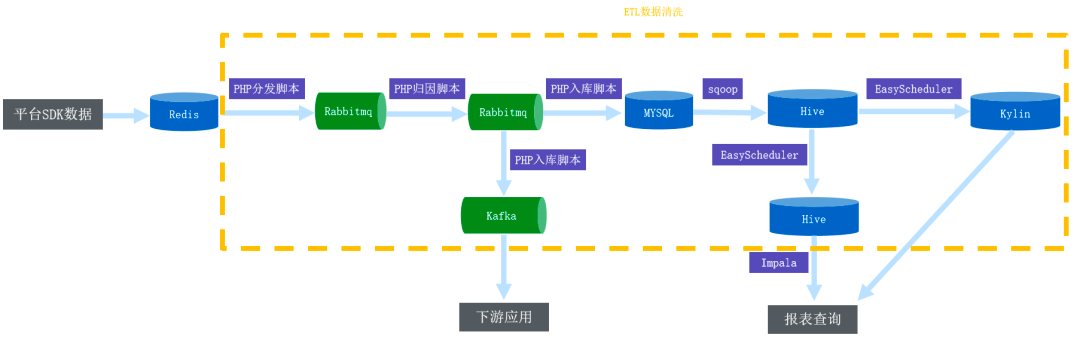

《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践(2) https://developer.aliyun.com/article/12284702. 实时数据集成 主要分为两个部分: 第一部分是实时数据的收集,小米内...

《Apache Flink 案例集(2022版)》——1.数据集成——小米-Flink 流批一体在小米的实践(3)

2. 实时数据集成 主要分为两个部分: 第一部分是实时数据的收集,小米内部主要分为两大类, 分别是日志数据和 DB 的 Binlog 数据。这里主要介绍 DB 系统的 Binlog 数据收集。最初小米使用自研的 LCS Binlog 服务来进行统一的 Binlog 收集,类似...

《Apache Flink 案例集(2022版)》——1.数据集成——37手游-基于 Flink CDC + Hudi 湖仓一体方案实践

作者:徐润柏 用户背景 37手游着重强化自身游戏运营能力、市场推广能力、广告设计能力,提出了立体化、AI智能化营销的“流量经营”策略。37手游秉承“创新点亮梦想,分享成就未来”和“相信创造奇迹”的文化理念,强调创新、分享、自信、梦想和追求的经营理念。 业务需求37手游的原有技术架...

《Apache Flink 案例集(2022版)》——1.数据集成——XTransfer-基Flink MongoDB CDC 在 XTransfer 的生产实践(上)

作者:孙家宝 用户背景 XTransfer 专注为跨境 B2B 电商中小企业提供跨境金融和风控服务,通过建立数据化、自动化、互联网化和智能化的风控基础设施,搭建通达全球的财资管理平台,提供开立全球和本地收款账户、外汇兑换、海外外汇管制国家申报等多种跨境金融服务的综合解决方案。 业...

《Apache Flink 案例集(2022版)》——1.数据集成——XTransfer-基Flink MongoDB CDC 在 XTransfer 的生产实践(下)

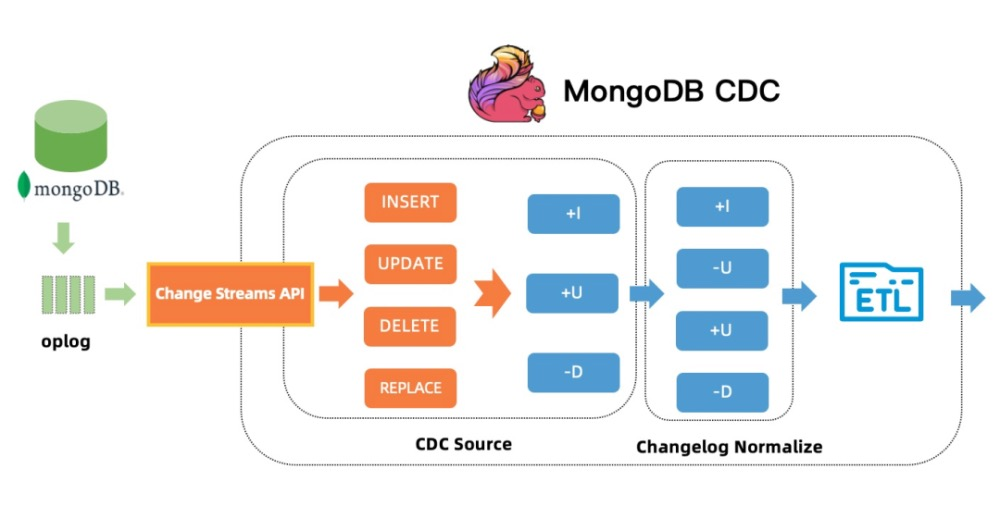

《Apache Flink 案例集(2022版)》——1.数据集成——XTransfer-基Flink MongoDB CDC 在 XTransfer 的生产实践(上) https://developer.aliyun.com/article/1228399生产实践 在实际的生产使用过程当中,XTr...

[帮助文档] 如何实现Flink+DLF数据入湖与分析

数据湖构建(DLF)可以结合阿里云实时计算Flink版(Flink VVP),以及Flink CDC相关技术,实现灵活定制化的数据入湖。并利用DLF统一元数据管理、权限管理等能力,实现数据湖多引擎分析、数据湖管理等功能。本文为您介绍Flink+DLF数据湖方案具体步骤。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版实践相关内容

- 实时计算 Flink版自定义实践

- 实时计算 Flink版产品实践

- 实时计算 Flink版hudi实践

- 实时计算 Flink版hologres实践

- 实时计算 Flink版数据湖实践

- 实时计算 Flink版实时数据湖实践

- 实时计算 Flink版优化实践

- 小米实时计算 Flink版实践

- 实时计算 Flink版字节跳动实践

- 实时计算 Flink版数仓实践

- smartnews实时计算 Flink版实践

- 实时计算 Flink版k8s实践

- 全托管实时计算 Flink版实践

- 实时计算 Flink版平台实践

- 实时计算 Flink版大规模实践

- 实时计算 Flink版数据集成实践

- 实时计算 Flink版集成实践

- 实时计算 Flink版湖仓一体实践

- 实时计算 Flink版数据分析实践

- 实时计算 Flink版快手扩展实践

- apacheflink案例集(2022版)实时计算 Flink版实践

- 实时计算 Flink版机器学习实践

- apacheflink案例集(2022版)机器学习实时计算 Flink版实践

- 云原生实时计算 Flink版实践

- apacheflink案例集(2022版)数字化转型实时计算 Flink版实践

- 实时计算 Flink版移动云实践

- 实时计算 Flink版catalog实践

- 引擎实时计算 Flink版实践

- 实时计算 Flink版原理实践

- 实时计算 Flink版k8s原理实践

- 网易实时计算flink版支付环境实践

- 实时计算flink版流批一体实践

- 实时计算flink版小米实践

- 实时计算 Flink版meetup实践

- 实时计算 Flink版探索实践

- g7实时计算 Flink版实践

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版gbase

- 实时计算 Flink版并行度

- 实时计算 Flink版数据

- 实时计算 Flink版回滚

- 实时计算 Flink版同步

- 实时计算 Flink版killed

- 实时计算 Flink版批处理

- 实时计算 Flink版任务

- 实时计算 Flink版作业

- 实时计算 Flink版报错

- 实时计算 Flink版oracle

- 实时计算 Flink版版本

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版连接

- 实时计算 Flink版库

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版集群

- 实时计算 Flink版日志