经典神经网络论文超详细解读(五)——ResNet(残差网络)学习笔记(翻译+精读+代码复现)

前言《Deep Residual Learning for Image Recognition》这篇论文是何恺明等大佬写的,在深度学习领域相当经典,在2016CVPR获得best paper。今天就让我们一起来学习一下吧!论文原文:https://arxiv.org/abs/1512.03385Ab...

最快ViT | FaceBook提出LeViT,0.077ms的单图处理速度却拥有ResNet50的精度(文末附论文与源码)(二)

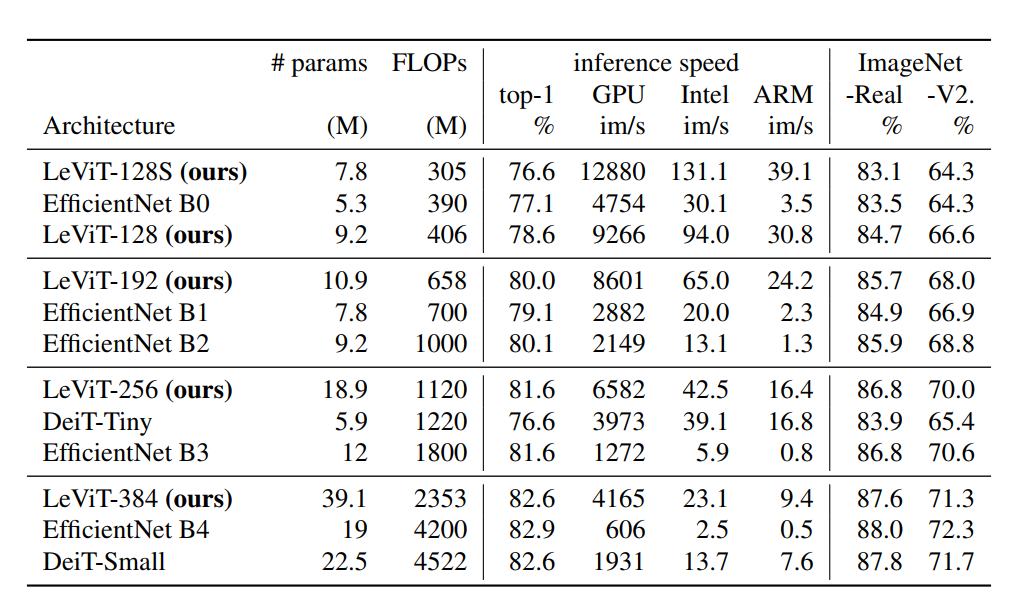

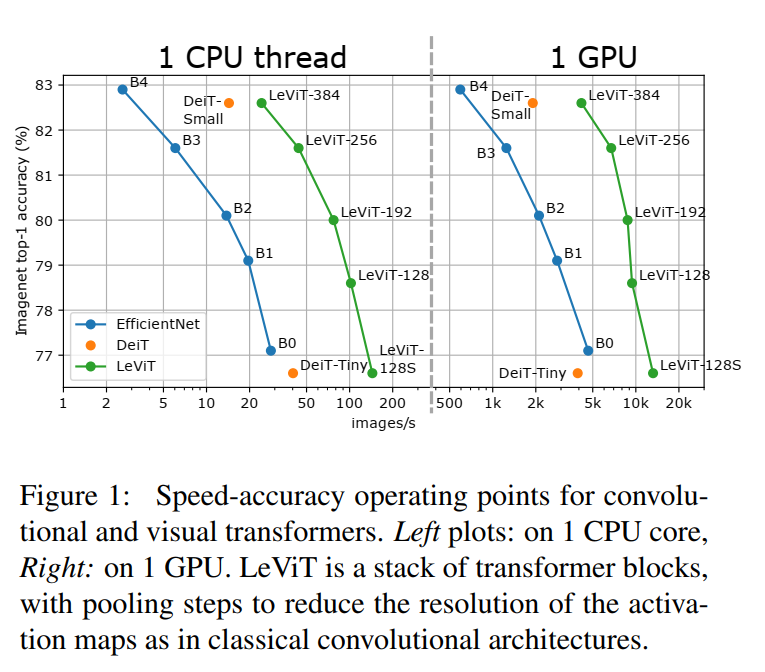

3 实验3.1 速度对比ResNet50的精度,但是是起飞的速度。3.2 SOTA对比4 参考[1].LeViT: a Vision Transformer in ConvNet’s Clothing for Faster Inference[2].https://github.com/facebo...

最快ViT | FaceBook提出LeViT,0.077ms的单图处理速度却拥有ResNet50的精度(文末附论文与源码)(一)

1 简介本文的工作利用了基于注意力体系结构中的最新发现,该体系结构在高度并行处理硬件上具有竞争力。作者从卷积神经网络的大量文献中重新评估了原理,以将其应用于Transformer,尤其是分辨率降低的激活图。同时作者还介绍了Attention bias,一种将位置信息集成到视觉Transformer中...

又改ResNet | 重新思考ResNet:采用高阶方案的改进堆叠策略(附论文下载)(二)

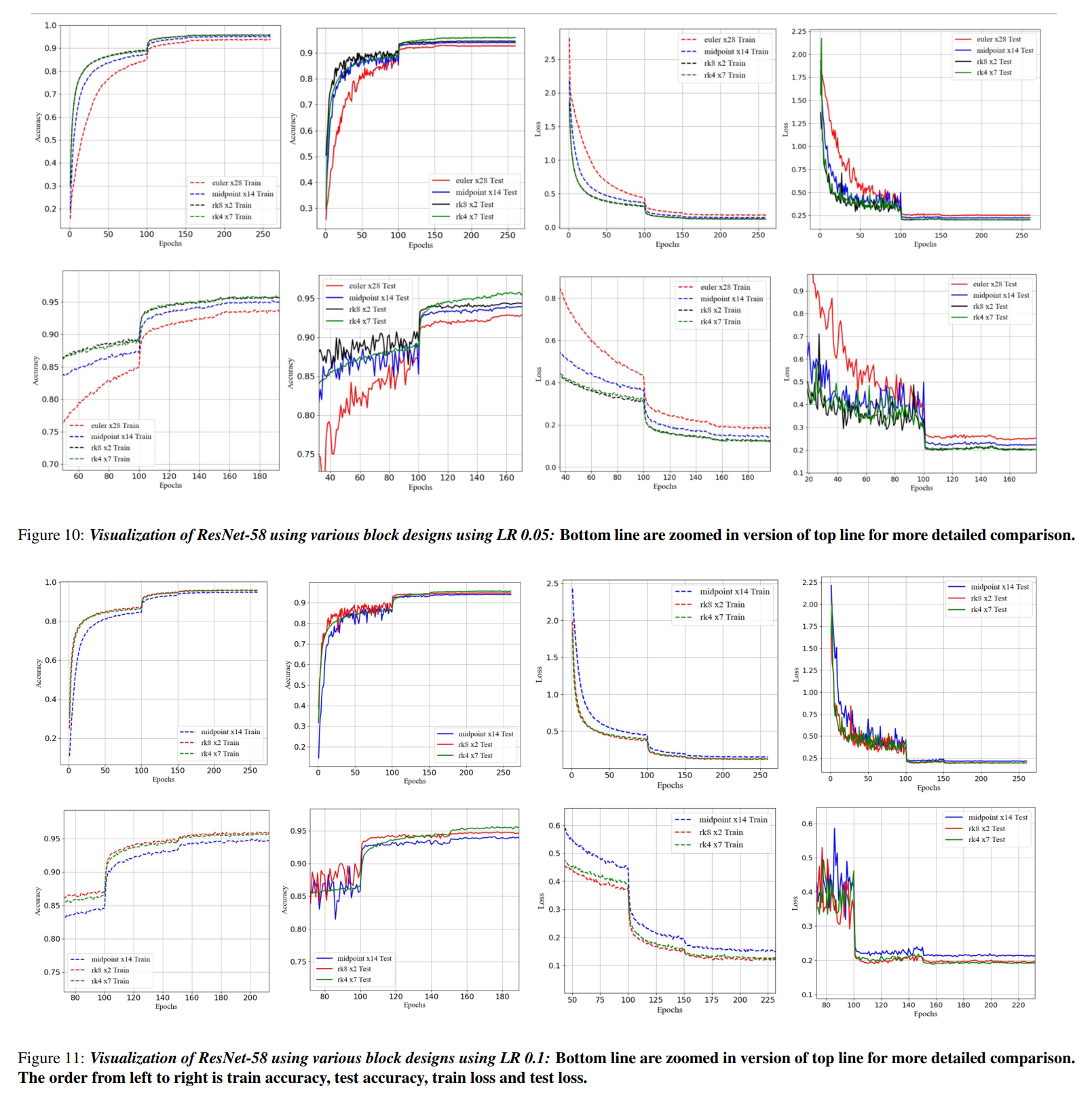

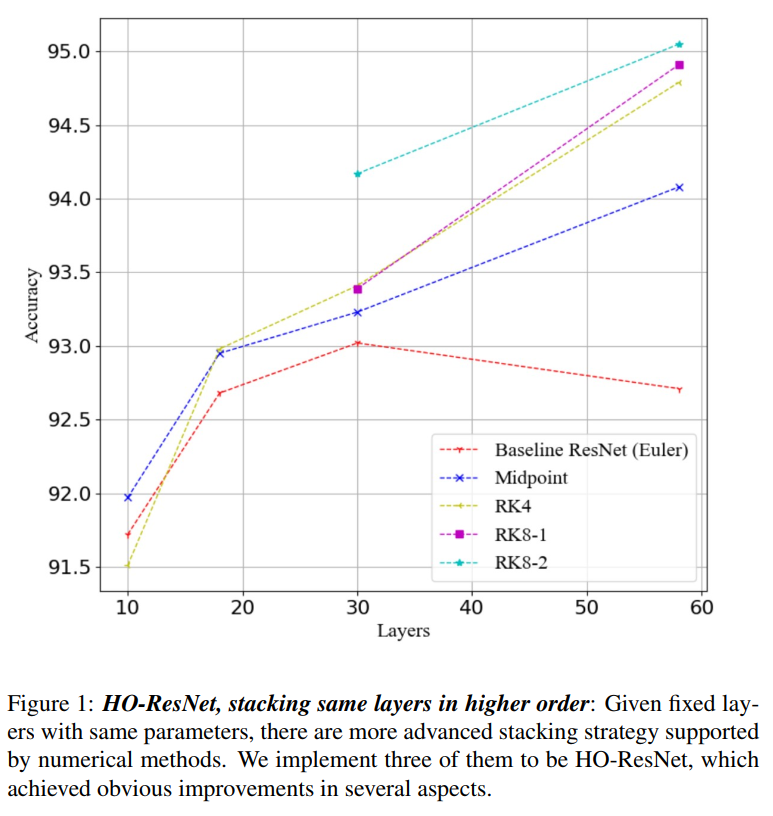

3 实验如图10所示,在相同的设置和参数下,采用高阶叠加方法,红线所代表的基线ResNet得到了明显的改善。作者注意到fixed RK8方法有改进的潜力。它在早期阶段高于RK-4。在Verner的设计中,还应保持一个比例因子h和误差来调整台阶侧。作者认为是固定步长导致RK-8退化到RK-4。由于收敛...

又改ResNet | 重新思考ResNet:采用高阶方案的改进堆叠策略(附论文下载)(一)

1 简介本文提出了更高阶的ResNet变体:HO-ResNet,平均涨2+个点!并进行了大量实验验证到该方法可以使性能显著的提高的同时也有助于模型的收敛和鲁棒性。(居然连ResNet-RS都引用了,太卷了)文章总结到网络整体结构的设计缺乏一般性的指导。基于近年来一些研究人员观察到的DNN设计与数值微...

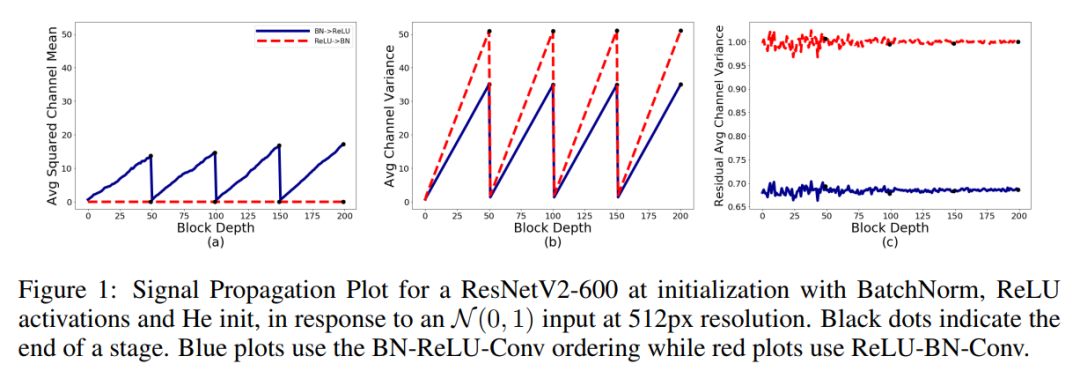

Backbone | What?没有Normalize也可以起飞?全新Backbone之NF-ResNet(文末获取论文与源码)

1简介Batch Normalization几乎是所有最新图像分类器中的关键组件,但同时也带来了实际挑战:它打破了Batch内训练样本之间的独立性,可能会导致计算和内存的开销,并经常导致意外的错误。基于对初始化时深度ResNet的最新理论分析,本文提出了一套简单的分析工具来表征前向信号的传播,并利用...

经典神经网络 | ResNet 论文解析及代码实现

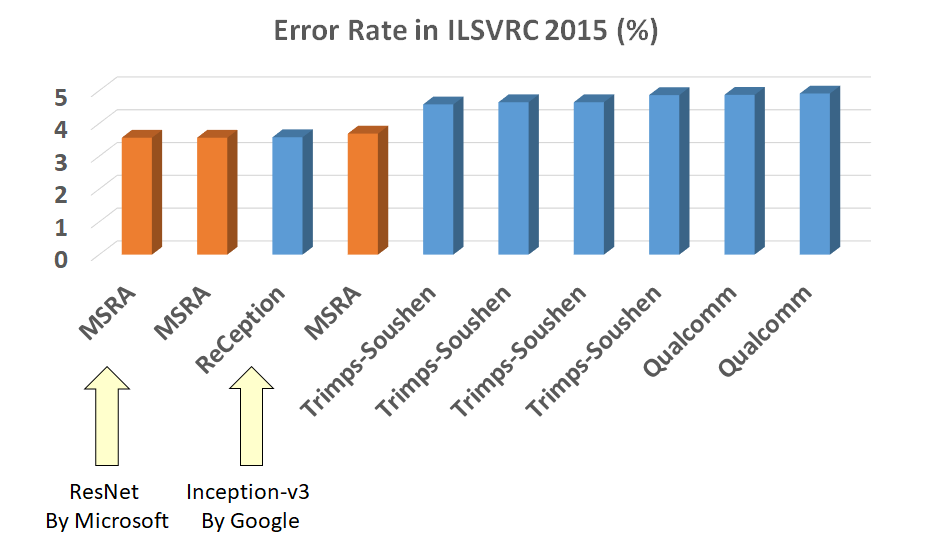

论文题目:Deep Residual Learning for Image Recognition论文地址:https://arxiv.org/pdf/1512.03385.pdf前言ResNet是2015年ImageNet比赛的冠军,将识别错误率降低到了3.6%,这个结果甚至超出了正常人眼识别的精...

【论文泛读】 ResNeXt:深度神经网络的聚合残差变换(ResNet的改进,提出了一种新的维度)

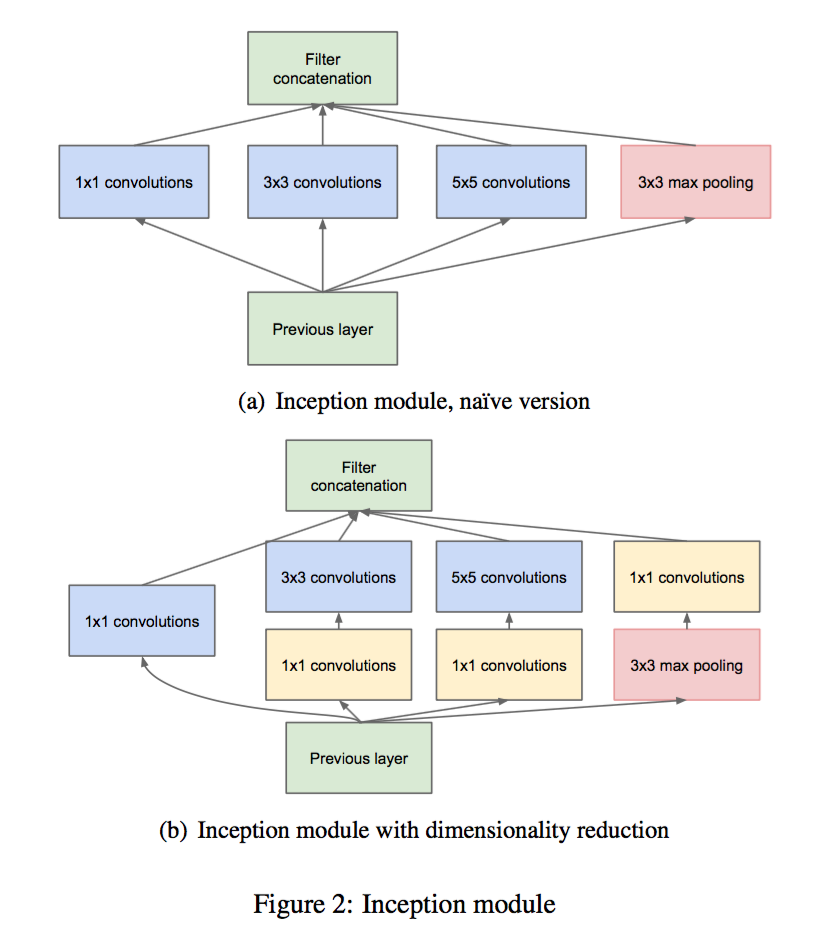

主要思想简单来说呢,随着很多SOTA模型的出现,从一开始的“特征工程”慢慢地转入了一些“网络工程”,引入了一些新的结构和方法。在前面说过的网络中呢,VGG作为一种经典的模型,他提出了堆叠相同块(stacking block)的策略,在VGG中是3x3卷积核不断堆叠,并且也...

【论文泛读】 ResNet:深度残差网络

当大家还在惊叹 GoogLeNet 的 inception 结构的时候,微软亚洲研究院的研究员已经在设计更深但结构更加简单的网络 ResNet,并且凭借这个网络子在 2015 年 ImageNet 比赛上大获全胜,除此之外,在那时的五个比赛都拿了第一名接下来我们仔细阅读以下这篇论文摘要 Abstra...

论文笔记系列:主干网络(一)-- ResNet

论文结构摘要: 深度网络训练难;残差网络可训练1000层网络;成就。1. Introduction: 提出深层网络存在模型退化问题;分析问题并提出残差学习策略、2. Related Work: 列举残差学习应用例子;单独用一段对比Highway Network。3. Deep Residual Le...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。