一篇文章教会你理解和定义Scrapy爬虫框架中items.py文件

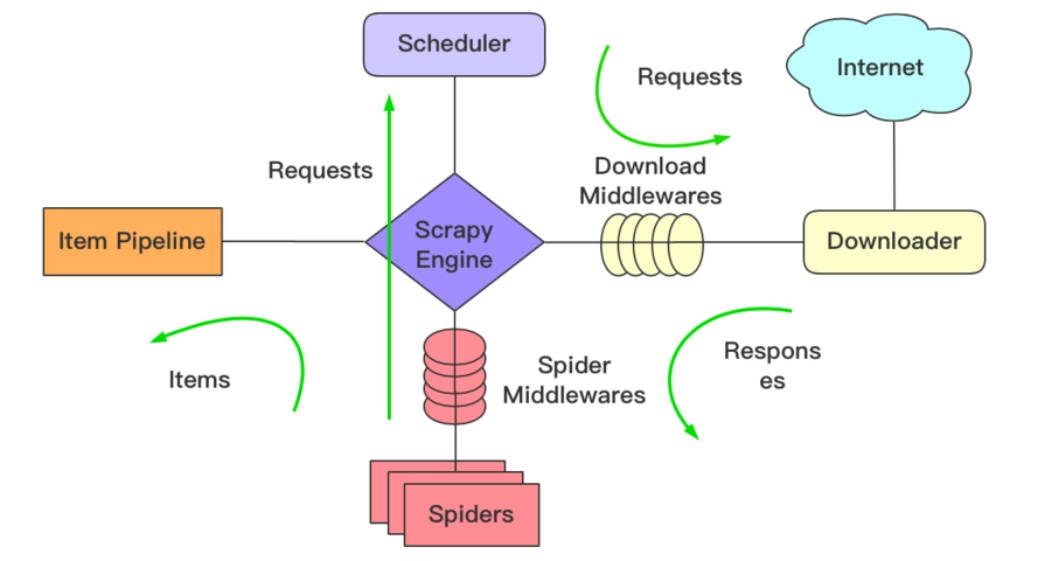

在前面几篇文章中我们已经学会了如何了编写Spider去获取网页上所有的文章链接及其对应的网页目标信息。在这一篇文章中,我们将主要介绍Scrapy中的Item。 在介绍Item之前,我们需要知道明确一点,网络爬虫的主要目标就是需要从非结构化的数据源中提取出结构化的数据,在提取出结构化的数据之后,怎么将...

从python / scrapy(python framework)在单个csv文件中将数据写入多个

我正在使用scrapy框架,并通过创建两个蜘蛛文件从两个url获取数据。 现在,例如,当我运行时spider1,url1所抓取的数据将保存到csv1文件中,而当我运行第二次时spider2,数据将保存到csv2文件中。 实际上我想做的是将来自不同Spider的所有数据保存到不同工作表中的单个CSV文...

scrapy框架中如何实现大文件的下载?

scrapy框架中如何实现大文件的下载?

在scrapy中,如何在一个爬虫文件中对不同的url进行爬取?

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

23、 Python快速开发分布式搜索引擎Scrapy精讲—craw母版l创建自动爬虫文件—以及 scrapy item loader机制

转: http://www.bdyss.cn http://www.swpan.cn 用命令创建自动爬虫文件 创建爬虫文件是根据scrapy的母版来创建爬虫文件的 scrapy genspider -l 查看scrapy创建爬虫文件可用的母版 Available templat...

20、 Python快速开发分布式搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

编写spiders爬虫文件循环抓取内容 Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数, 参数: url='url' callback=页面处理函数 使用时需要yield Request() parse.urljoin()方法,是urllib库下的方法,是自动u...

scrapy自带文件下载器,实现多层级目录结构的存储

概scrapy既然是一款强大的爬虫框架,自然也实现了图片和文件的下载,FilesPipeline、ImagesPipeline分别是图片和文件的下载器,image也是文件的一种为什么还要单独提供一个image下载器?这是因为图片下载器还提供了一些额外方法:缩略图生成、图片过滤;今天就来...

最近在学习scrapy,有个保存文件的文件困扰几天了,哪位给指导下,不胜感激!

我要导出为excel文件,用的是openpyxl,下面第一种写法可以保存所有数据。 import scrapy from clo.items import CloItem class ClooSpider(scrapy.Spider): ...

scrapy框架-将数据写入json文件

使用背景 有时候为了做测试,不想去数据库设置字段,设置musql字段实在是太麻烦了,这种情况下可以先把存储到json文件中,并观察数据的正确性,如果数据没问题了,再改成mysql存储即可。 有时候任务本身就是要存储进json文件中。 有时候为了更好的阅读数据,看结构,json文件是一个不错的选择 j...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子