百度搜索:蓝易云【Scrapy框架之Docker安装MongoDB教程。】

以下是关于在Scrapy框架中使用Docker安装MongoDB的教程: 配置Docker环境:确保你已经安装并正确配置了Docker。你可以从Docker官方网站下载适合你操作系统的Docker版本,并按照官方文档进行安装和配置。 下载MongoDB镜像:在终端或命令提示符中执行以下命令,从Doc...

Scrapy爬虫(6)爬取银行理财产品并存入MongoDB(共12w+数据)

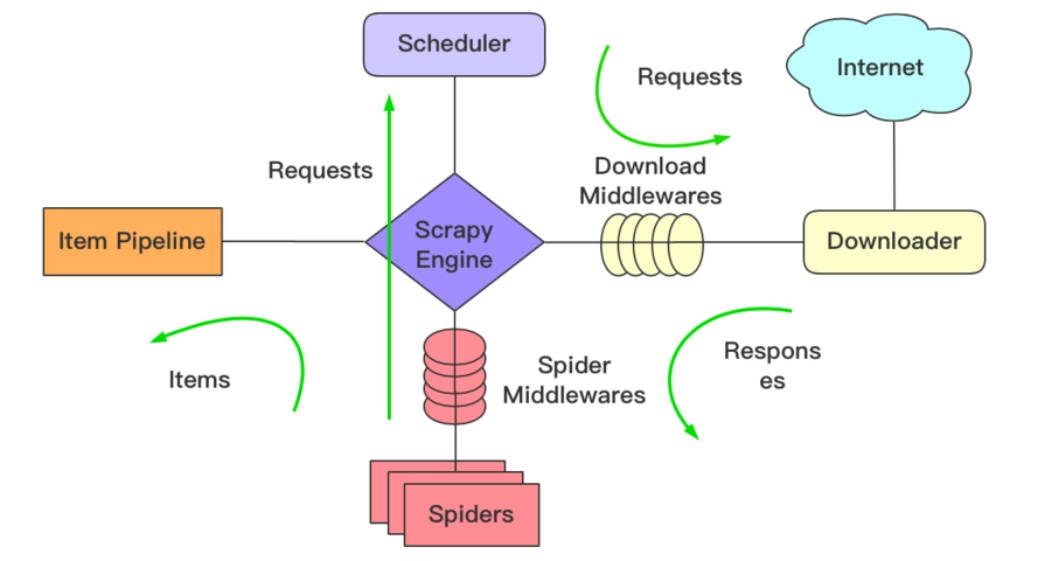

本次Scrapy爬虫的目标是爬取“融360”网站上所有银行理财产品的信息,并存入MongoDB中。网页的截图如下,全部数据共12多万条。 我们不再过多介绍Scrapy的创建和运行,只给出相关的代码。关于Scrapy的创建和运行,有兴趣的读者可以参考:Scrapy爬虫(4)爬取豆瓣电影Top2...

Scrapy爬虫(3)爬取中国高校前100名并写入MongoDB

在以前 的分享中,我们利用urllib和BeautifulSoup模块爬取中国高校排名前100名并将其写入MySQL.在本次分享中,我们将会用到Scrapy和BeautifulSoup模块,来爬取中国高校排名前100名并将其写入MongoDB数据库。爬取的网页为:http://gaokao.xdf....

Scrapy 爬虫实例 抓取豆瓣小组信息并保存到mongodb中

这个框架关注了很久,但是直到最近空了才仔细的看了下 这里我用的是scrapy0.24版本 先来个成品好感受这个框架带来的便捷性,等这段时间慢慢整理下思绪再把最近学到的关于此框架的知识一一更新到博客来。 最近想学git 于是把代码放到 git-osc上了: https://git.osch...

scrapy+mongodb 插入文档的数目不够的原因?

我使用mongo储存scrapy爬下来的页面数据,在管道中为同时向db和txt中写入结果,结果发现txt有8000多条记录,而db中count才831条,百思不得其解。后来将db中数据导出,发现似乎是item['content'](文章内容)字段内容比较多的就没有成功插入db。后来想了下,似乎是db...

scrapy+mongodb insert的文档数目不够

我使用mongo储存scrapy爬下来的页面数据,在管道中为同时向db和txt中写入结果,结果发现txt有8000多条记录,而db中count才831条,百思不得其解。后来将db中数据导出,发现似乎是item['content'](文章内容)字段内容比较多的就没有成功插入db。后来想了下,似乎是db...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子