Flink报错问题之flink-sql写hdfs报错如何解决

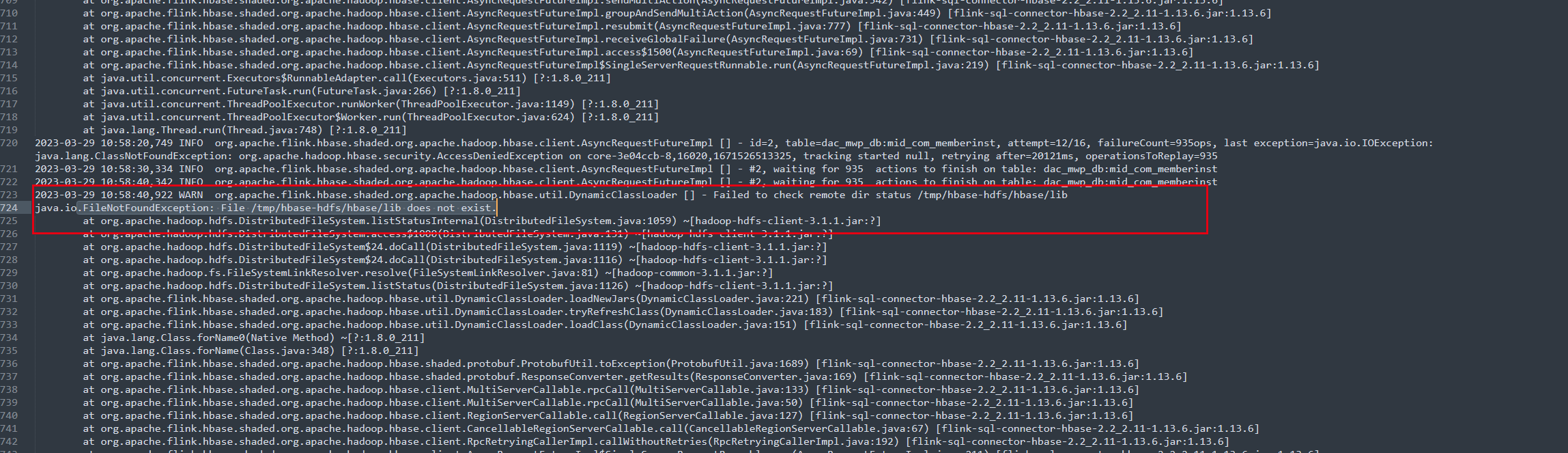

问题一:在使用flink-sql-connnect-hbase的时候老是出现这个报错是什么原因呢 问下我在使用flink-sql-connnect-hbase的时候老是出现这个报错是什么原因呢 ...

大佬们,flink sql写hdfs怎么控制小文件数量啊?配置了一堆参数,都没效果啊

大佬们,flink sql写hdfs怎么控制小文件数量啊?配置了一堆参数,都没效果啊

flink sql写hdfs的时候时间字段自动加了双引号,怎么去掉啊,有大佬知道是哪个参数吗?

flink sql写hdfs的时候时间字段自动加了双引号,怎么去掉啊,有大佬知道是哪个参数吗?

Flink sql方式可以直接写HDFS吗?不要通过Hive实现,有的帮忙发个demo,谢了?

Flink sql方式可以直接写HDFS吗?不要通过Hive实现,有的帮忙发个demo,谢了

大佬们flink-sql写hdfs这个报错是什么情况啊?flink版本:1.14.6

大佬们flink-sql写hdfs这个报错是什么情况啊?flink版本:1.14.6

1.13.6版本 flink sql 写hive 任务正常,hdfs上有文件,但是发现缺乏_SU

1.13.6版本 flink sql 写hive 任务正常,hdfs上有文件,但是发现缺乏_SUCCESS 标记文件,与hive分区也没有创建 ,有谁知道什么原因?

Sqoop中sql语句如何查找导入hdfs?

Sqoop中sql语句如何查找导入hdfs?

flink的sql写hdfs如何指定文件名称

flinksql写HDFS后自动生成的名称:part-c4a19762-bde3-4f37-8b3c-b92d182b450c-task-0-file-0 然后发现我读取的时候麻烦了,请问如何指定flink的sql写hdfs如何指定文件名称 陈 *来自志愿者整理的flink邮件归档

flink 1.11 使用sql写入hdfs无法自动提交分区

我在用flink 1.11 的sql从kafka消费然后写入hdfs的过程中,发现没法自动提交分区,请问这个是什么原因呢?谢谢 我的checkpoint设置了间隔10s,对于如下的配置,正常应该是每隔10在hdfs相应的分区下会有_SUCCESS文件,但是实际上过了好久也没有,ORC格式的结果数据是...

flink sql 写hdfs问题,如何解决?

flink.version=1.12.0 Create table t1( a varchar )with ( connector=kafka format=json ) Create table t2( a varchar )with ( connector=filesystem format=c...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版文件

- 文件存储HDFS版flink

- 文件存储HDFS版parquet

- 文件存储HDFS版设置

- 文件存储HDFS版格式

- 文件存储HDFS版hive

- 文件存储HDFS版映射

- 文件存储HDFS版cdc

- 文件存储HDFS版javaapi

- 文件存储HDFS版测试

- 文件存储HDFS版hadoop

- 文件存储HDFS版数据

- 文件存储HDFS版大数据

- 文件存储HDFS版操作

- 文件存储HDFS版api

- 文件存储HDFS版命令

- 文件存储HDFS版java

- 文件存储HDFS版集群

- 文件存储HDFS版存储

- 文件存储HDFS版文件存储

- 文件存储HDFS版配置

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版架构

- 文件存储HDFS版读取

- 文件存储HDFS版namenode

- 文件存储HDFS版mapreduce