Spark Streaming保存计算状态

一、实验目的掌握 DStream数据累加函数updateStateByKey。 掌握 DStream数据累加函数mapWithState。二、实验内容1、每5秒钟计算一次每个单词出现的累加数量。(使用Socket数据源)三、实验原理在DStream中支持跨批次数据执行计算时保持任意状态。在Spar...

Spark Streaming开发基础

1. 实验室名称:大数据实验教学系统2. 实验项目名称:Spark Streaming开发基础3. 实验学时:4. 实验原理:Spark Core它的核心就是RDD,对于Spark Streaming来说,它的核心是DStream,DStream类似于RDD,它实质上一系列的RDD的集...

spark streaming知识总结[优化]

RDD与job之间的关系Spark Streaming是构建在Spark上的实时流计算框架,扩展了Spark流式大数据处理能力。Spark Streaming将数据流以时间片为单位分割形成RDD,使用RDD操作处理每一块数据,每块数据(也就是RDD)都会生成一个Spark Job进行处理,最终以批处...

让你真正明白spark streaming

spark streaming介绍Spark streaming是Spark核心API的一个扩展,它对实时流式数据的处理具有可扩展性、高吞吐量、可容错性等特点。我们可以从kafka、flume、witter、 ZeroMQ、Kinesis等源获取数据,也可以通过由 高阶函数map、reduce、jo...

5万字Spark全集之末尾Structured Streaming续集!!!!!(二)

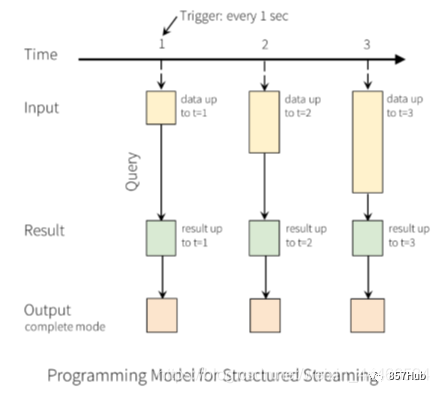

6、output mode每当结果表更新时,我们都希望将更改后的结果行写入外部接收器。这里有三种输出模型:1.Append mode:输出新增的行,默认模式。每次更新结果集时,只将新添加到结果集的结果行输出到接收器。仅支持添加到结果表中的行永远不会更改的查询。因此,此模式保证每行仅输出一次。例如,仅...

5万字Spark全集之末尾Structured Streaming续集!!!!!(一)

九、Structured Streaming曲折发展史1、Spark StreamingSpark Streaming针对实时数据流,提供了一套可扩展、高吞吐、可容错的流式计算模型。Spark Streaming接收实时数据源的数据,切分成很多小的batches,然后被Spark Engine执行,...

Spark Streaming实时流处理项目实战笔记——使用KafkaSInk将Flume收集到的数据输出到Kafka

Flume配置文件a1.sources = r1 a1.sinks = k1 a1.channels = c1 a1.sources.r1.type = avro a1.sources.r1.bind = hadoop a1.sources.r1.port = 44444 a1.sinks.k1.t...

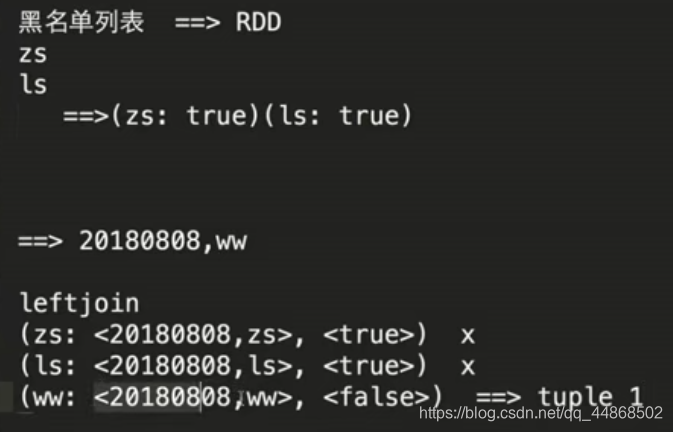

Spark Streaming实时流处理项目实战笔记——实战之黑名单过滤

思路源代码窗口函数 代码实现object Black extends App { import org.apache.spark.SparkConf import org.apache.spark.streaming.{Seconds, StreamingContext} val spa...

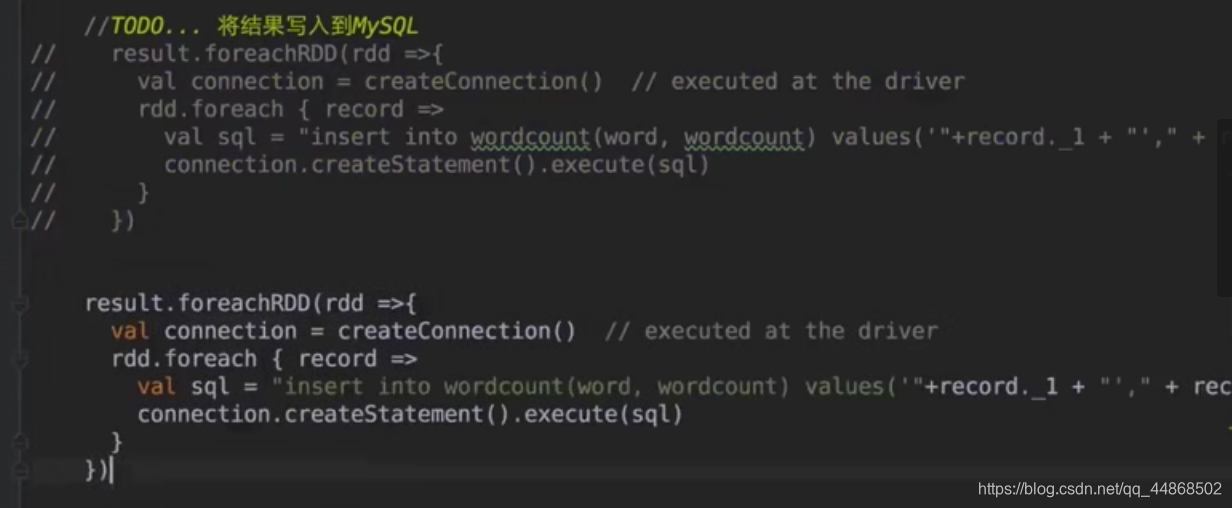

Spark Streaming实时流处理项目实战笔记——将统计结果写入到MySQL数据库中

思路两种方式,一种可优化(foreachRDD后,直接创建连接Mysql),一种在(foreachRDD后通过foreachPartition,通过分区获取)代码实现import java.sql.DriverManager import Spark.UpdateStateByKey....

Spark Streaming实时流处理项目实战笔记——Kafka Consumer Java API编程

1、在控制台创建发送者kafka-console-producer.sh --broker-list hadoop2:9092 --topic zz >hello world2、消费者APIimport java.util.Arrays; import java.util.Properties...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark更多streaming相关

- apache spark streaming区别

- flink apache spark streaming

- apache spark Streaming容错性

- apache spark streaming数据源

- apache spark streaming dstream操作

- apache spark streaming操作

- apache spark streaming简介

- apache spark streaming学习笔记

- apache spark streaming wordcount

- apache spark structured streaming

- apache spark Streaming Kafka

- apache spark streaming计算

- apache spark streaming方法

- apache spark streaming checkpoint

- apache spark streaming小文件

- apache spark streaming作用是什么

- apache spark Streaming原理

- apache spark入门streaming

- 大数据apache spark streaming

- apache spark streaming文件典型

- apache spark streaming direct

- apache spark summit eu streaming

- apache spark streaming loghub

- apache spark streaming应用

- apache spark streaming实战

- apache spark streaming作业运行

- apache spark streaming项目实战笔记

- apache spark streaming实时计算

- apache spark streaming服务

- apache spark streaming框架

- apache spark streaming sql pv uv统计

- flink相比传统apache spark streaming区别

- apache spark streaming分析

- apache spark streaming运行

- apache spark streaming优化

- apache spark streaming流处理

- apache spark streaming receiver

- apache spark streaming foreachrdd

- apache spark streaming编程

- apache spark streaming文件

- 流式计算apache spark streaming

- apache spark streaming kafka stream

- apache spark streaming算子

- apache spark streaming架构原理

- apache spark streaming容错机制

- apache spark streaming连接kafka

- apache spark streaming流计算

- kafka apache spark streaming

- apache spark streaming文件典型是什么意思

- apache spark streaming应用程序

apache spark您可能感兴趣

- apache spark分析

- apache spark数据

- apache spark数据库

- apache spark可视化分析

- apache spark决策

- apache spark可视化

- apache spark Mapreduce

- apache spark SQL

- apache spark Python

- apache spark决策树

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark rdd

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark机器学习

- apache spark实战

- apache spark Scala

- apache spark flink

- apache spark任务

- apache spark程序