函数计算FC的nas版本建了一个模型,是不是换成自定义镜像用硬盘换gpu资源来的划算呢?

函数计算FC有一个培训项目里面计算冷启动的时候时间是计算用量的这个,nas版本的我也建了一个加载两g的模型18秒 4g的30多秒 是不是换成自定义镜像用硬盘换gpu资源来的划算呢? 还剩加载等待时间不知道有没人能说清楚

您好 问下 AIGC模型 是 国外网站 下载 国内gpu服务器 不能 下载 怎么办 ?

您好 问下 AIGC模型 是 国外网站 下载 国内gpu服务器 不能 下载 怎么办 ?

请问ModelScope中,这个翻译模型,我指定了device为GPU了,但是实际运行中还是cpu,

https://modelscope.cn/models/damo/nlp_csanmt_translation_en2zh/summary 请问ModelScope中,这个翻译模型,我指定了device为GPU了,但是实际运行中还是cpu,是什么原因?

翻译模型。我指定了device为GPU了。但是实际运行中还是cpu,有没有遇到的

翻译模型。我指定了device为GPU了。但是实际运行中还是cpu,有没有遇到的 这是什么原因呢

ModelScope这个模型不支持GPU多卡吗?这里设置2,但是从nVidia-smi上看,只有一张

问题1:https://modelscope.cn/models/damo/nlp_csanmt_translation_en2zh/summary ModelScope这个模型不支持GPU多卡吗? 这里设置2,但是从nVidia-smi上看,只有一张卡在跑。是不是因为使用的是导出的savedmod...

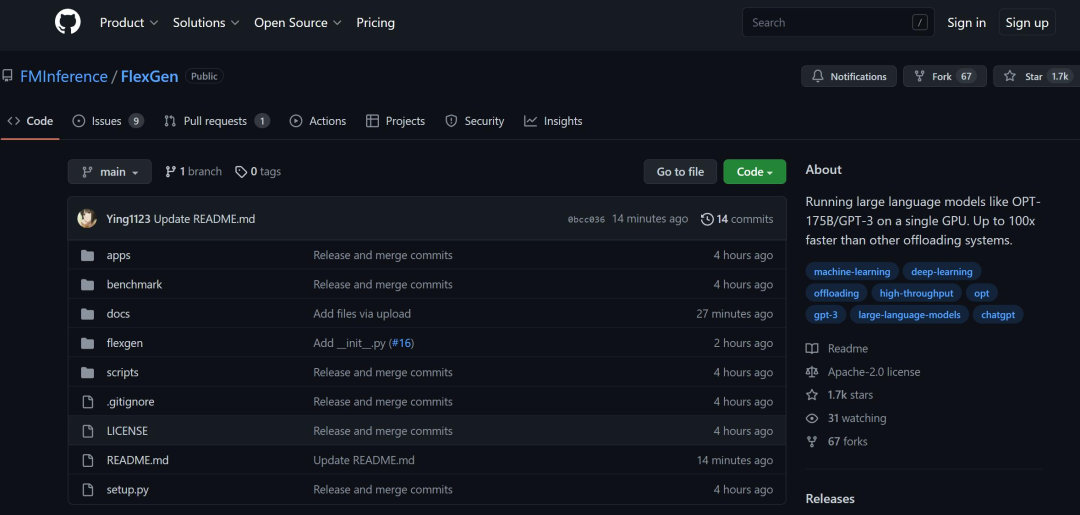

跑ChatGPT体量模型,从此只需一块GPU:加速百倍的方法来了

1750 亿参数,只需要一块 RTX 3090,ChatGPT 终于不再是大厂专属的游戏?计算成本是人们打造 ChatGPT 等大模型面临的重大挑战之一。据统计,从 GPT 进化到 GPT-3 的过程也是模型体量增长的过程 —— 参数量从 1.17 亿增加到了 1750 亿,预训练数据量从 5GB ...

将GPT家族模型极限压缩,1700+亿参数稀疏性达50%性能不减,单GPU即可

机器之心编译编辑:袁铭怿我们可以压缩大型语言模型以获得更好的性能吗?本文中,研究者提出了剪枝技术 SparseGPT,可以一次性修剪至少 50% 的稀疏性,而无需任何重新训练,并且准确率损失最小。GPT 家族的大型语言模型(LLMs)在诸多任务中取得了出色的表现,但模型庞...

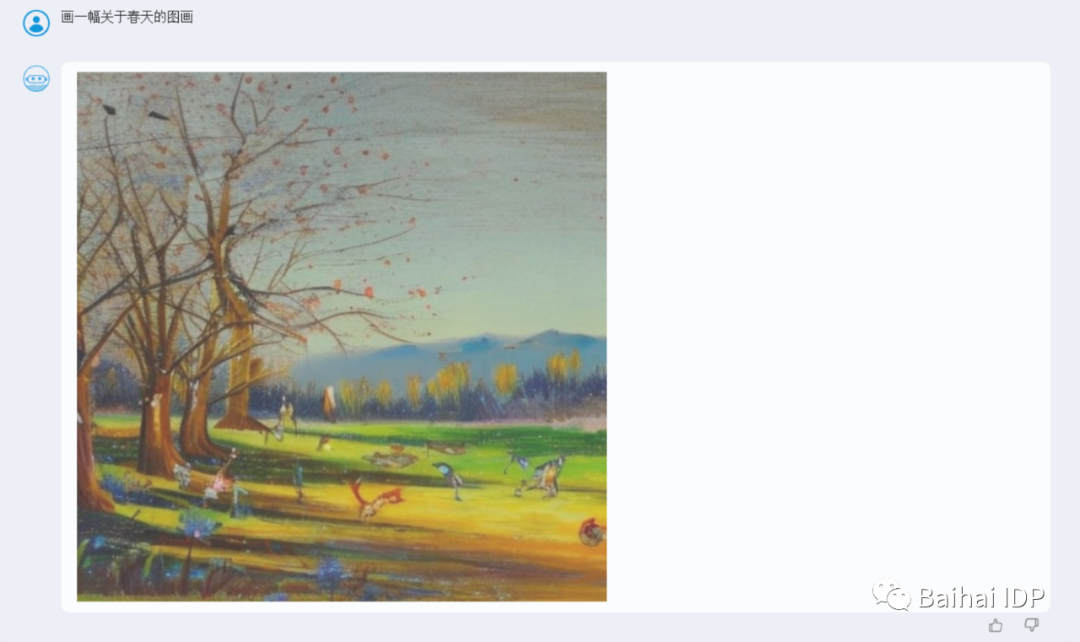

中文多模态模型问世!IDPChat生成图像文字,只需5步+单GPU

新智元报道 编辑:桃子 拉燕【新智元导读】中文多模态模型IDPChat来了,快速上手教程在此。中文多模态模型IDPChat和大家见面了。随着GPT4、文心一言等的发布,预训练大模型正式开启由单模态向多模态模型演进。多模态的特性为语言模型带来更加丰富的应用...

有大哥用过ModelScope这个模型吗?它是需要GPU环境才能部署吗?我用CPU环境部署它,报错了

有大哥用过ModelScope这个模型吗?它是需要GPU环境才能部署吗?我用CPU环境部署它,报错了。。。。 RuntimeError: Failed to import modelscope.models.nlp.mglm.mglm_for_text_summarization because o...

请问下GridVLP模型支持GPU吗? 我们修改了模型,启用GPU,发现GPU模块只是加载了,但实际

请问下GridVLP模型支持GPU吗? 我们修改了模型,启用GPU,发现GPU模块只是加载了,但实际上GPU上没有任务运行

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

GPU云服务器模型相关内容

- 函数计算fc模型GPU云服务器

- modelscope模型GPU云服务器推理

- 导出模型GPU云服务器

- modelscope模型GPU云服务器

- 模型GPU云服务器推理

- 模型设置GPU云服务器

- modelscope模型GPU云服务器运行

- 加载模型GPU云服务器

- GPU云服务器模型文件

- 模型GPU云服务器报错

- modelscope模型GPU云服务器报错

- pytorch模型GPU云服务器

- GPU云服务器加载模型

- GPU云服务器训练模型

- 自定义GPU云服务器模型文件

- GPU云服务器实验室模型

- 版本模型GPU云服务器

- GPU云服务器模型训练

- modelscope模型GPU云服务器设置

- GPU云服务器开源模型

- GPU云服务器文本模型

- 模型GPU云服务器环境

- pytorch GPU云服务器运行模型