Mixtral 8X7B MoE模型在阿里云PAI平台的微调部署实践

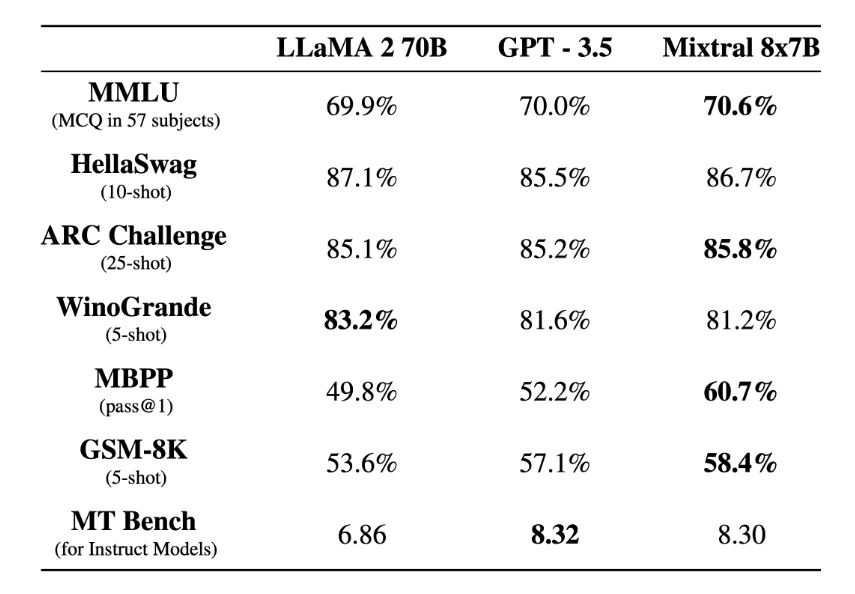

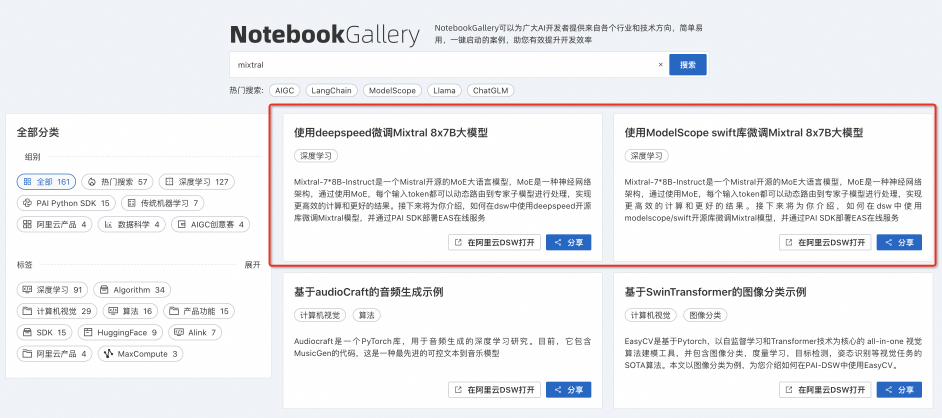

作者:熊兮、求伯、一耘引言Mixtral 8x7B 是Mixtral AI最新发布的大语言模型,在许多基准测试上表现优于 GPT-3.5,是当前最为先进的开源大语言模型之一。阿里云人工智能平台PAI是面向开发者和企业的机器学习/深度学习平台,提供了对于 Mixtral 8x7B 模型的全面支持,开发...

Mixtral 8X7B MoE模型基于阿里云人工智能平台PAI实践合集

作者:熊兮、贺弘、临在Mixtral 8x7B大模型是Mixtral AI推出的基于decoder-only架构的稀疏专家混合网络(Mixture-Of-Experts,MOE)开源大语言模型。这一模型具有46.7B的总参数量,对于每个token,路由器网络选择八组专家网络中的两组进行处理,并且将其...

通义千问开源模型在PAI灵骏的最佳实践

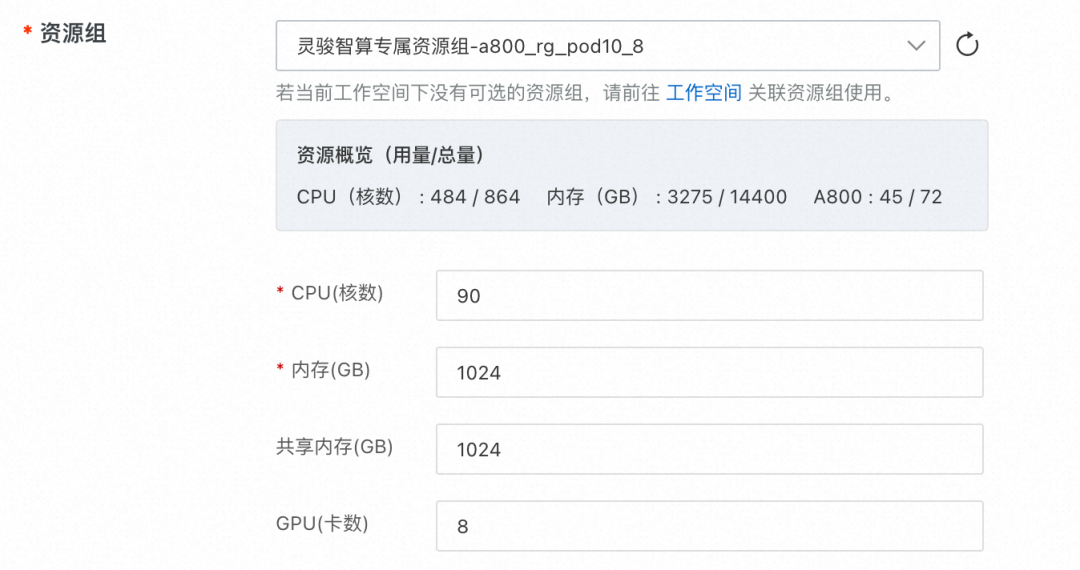

引言12月1日,通义千问再次宣布重磅开源,目前通义千问已推出1.8B、7B、14B、72B 四款不同尺寸的开源大语言模型。阿里云PAI灵骏智算服务,是面向大规模深度学习场景的智算产品,一站式提供异构算力底座及AI工程平台。本实践将展示如何基于阿里云PAI灵骏智算服务,在通义千问开源模型之上进行高效分...

在ModelScope中,一键部署模型PAI-EAS服务失败是什么原因?

一键部署模型PAI-EAS服务失败,报错原因如下截图,没能排查出错误原因,请求帮助。部署的是未公开模型,在本地可以正常使用,本地正常输出NER结果

ModelScope微调的模型,怎么在pai-eas上部署,有示例没有?

ModelScope微调的模型,怎么在pai-eas上部署,有示例没有?

模型在线服务(PAI-EAS)部署Stable Diffusion体验

通过阿里机器学习模型在线服务(PAI-EAS)来部署Stable Diffusion模型的过程是一次非常有趣且富有挑战性的经历。这个过程不仅让我深入了解了阿里强大的架构和PAI-EAS的强大功能,也让我对AI数字绘画有了更深的理解。 首先,我要说的是,使用模型在线服务(PAI-EAS)部署Stabl...

小白想问一下nas上面的模型怎么通过pai-eas进行使用

如题,今天想试用一下eas,发现根本不会,挂载nas后想使用我nas中存储的模型,实例无法启动,一直在pending,求解

请问多目标模型,比如essm机器学习PAI,可以用序列特征吗?

请问多目标模型,比如essm机器学习PAI,可以用序列特征吗?

机器学习Tensorflow模型如何部署到PAI-EAS

机器学习Tensorflow模型如何部署到PAI-EAS

第三方软件导出的pmml模型在机器学习PAI-EAS无法部署

第三方软件导出的pmml模型在机器学习PAI-EAS无法部署

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

机器学习平台 PAI模型相关内容

- 构建机器学习平台 PAI模型

- 机器学习平台 PAI模型优化

- 构建机器学习平台 PAI模型数据预处理优化

- 构建机器学习平台 PAI模型数据预处理

- 机器学习平台 PAI模型调优

- 构建机器学习平台 PAI模型调优

- 构建机器学习平台 PAI模型最佳实践

- 机器学习平台 PAI应用模型

- 构建机器学习平台 PAI模型数据处理

- 机器学习平台 PAI模型配置

- 机器学习平台 PAI部署模型

- 机器学习平台 PAI eas部署模型

- 机器学习平台 PAI eas模型

- 机器学习平台 PAI特征选择模型

- 机器学习平台 PAI模型策略

- 构建机器学习平台 PAI模型策略

- 机器学习平台 PAI模型数据预处理

- 构建机器学习平台 PAI模型数据预处理调优

- 机器学习平台 PAI可视化模型

- 机器学习平台 PAI可解释性模型

- 机器学习平台 PAI随机森林模型

- 机器学习平台 PAI训练模型

- 可解释性机器学习平台 PAI模型

- 机器学习平台 PAI xgboost模型

- 构建机器学习平台 PAI模型关键步骤

- 机器学习平台 PAI模型步骤

- 机器学习平台 PAI导出模型

- 机器学习平台 PAI alink模型

- 机器学习平台 PAI学习模型

- 机器学习平台 PAI组件模型

- 机器学习平台 PAI模型扩展

- 机器学习平台 PAI模型eas

- 机器学习平台 PAI模型推理

- 构建机器学习平台 PAI模型实践

- 机器学习平台 PAI arima模型

- 机器学习平台 PAI模型文件

- 机器学习平台 PAI模型样本

- 机器学习平台 PAI特征模型

- 机器学习平台 PAI模型评估

- 机器学习平台 PAI模型离线

- 机器学习平台 PAI模型数据

- 机器学习平台 PAI模型训练

- 机器学习平台 PAI pytorch模型

- 机器学习平台 PAI pb模型

- 机器学习平台 PAI easyrec模型

- 机器学习平台 PAI线性回归模型

- 学习机器学习平台 PAI模型

- 机器学习平台 PAI决策树模型

机器学习平台 PAI更多模型相关

- 机器学习平台 PAI模型参数

- 机器学习平台 PAI概率模型

- 机器学习平台 PAI diffusion模型

- gradio机器学习平台 PAI模型

- 机器学习平台 PAI评估模型

- 机器学习平台 PAI评估模型性能指标

- 机器学习平台 PAI模型加载

- 机器学习平台 PAI模型代码

- 机器学习平台 PAI模型监控

- 机器学习平台 PAI multitower模型

- 机器学习平台 PAI实战决策模型

- ml回归预测机器学习平台 PAI模型性能

- 阿旭机器学习平台 PAI实战决策树模型

- 机器学习平台 PAI模型参数优化

- 机器学习平台 PAI模型准确率

- 机器学习平台 PAI模型报错

- 建立机器学习平台 PAI模型

- 机器学习平台 PAI sklearn模型

- 机器学习平台 PAI入门模型

- 机器学习平台 PAI pai-eas模型

- 机器学习平台 PAI模型性能评估

- 机器学习平台 PAI模型中文分词

- 机器学习平台 PAI特征工程模型

- 机器学习平台 PAI模型knn

- 机器学习平台 PAI法中模型

- 机器学习平台 PAI训练模型部署

- 机器学习平台 PAI模型数据集

- 机器学习平台 PAI模型评价指标

- 机器学习平台 PAI模型评估presicion召回率recall

- 机器学习平台 PAI模型正则化

- 机器学习平台 PAI模型拟合

- 机器学习平台 PAI参数评估模型

- 机器学习平台 PAI逻辑回归模型

- 机器学习平台 PAI命令训练模型

- 机器学习平台 PAI实战特征模型

- 机器学习平台 PAI服务模型

- 机器学习平台 PAI模型验证

- 机器学习平台 PAI模型概念

- 线性回归模型机器学习平台 PAI

- 机器学习平台 PAI模型评分

- 机器学习平台 PAI studio模型

- 机器学习平台 PAI优化模型

- 机器学习平台 PAI模型schema

- 机器学习平台 PAI模型案例分析

- tensorflow机器学习平台 PAI模型

- 机器学习平台 PAI模型是什么意思

- 机器学习平台 PAI模型训练评估

- 机器学习平台 PAIsklearn模型

- 机器学习平台 PAI模型代价函数

机器学习平台 PAI您可能感兴趣

- 机器学习平台 PAI论文

- 机器学习平台 PAI代码

- 机器学习平台 PAI数字识别

- 机器学习平台 PAI实战

- 机器学习平台 PAI numpy

- 机器学习平台 PAI降维

- 机器学习平台 PAI构建

- 机器学习平台 PAIpai

- 机器学习平台 PAI升级

- 机器学习平台 PAI算法

- 机器学习平台 PAIpython

- 机器学习平台 PAI数据

- 机器学习平台 PAI应用

- 机器学习平台 PAI训练

- 机器学习平台 PAI人工智能

- 机器学习平台 PAI入门

- 机器学习平台 PAI方法

- 机器学习平台 PAI分类

- 机器学习平台 PAI深度学习

- 机器学习平台 PAI平台

- 机器学习平台 PAI笔记

- 机器学习平台 PAI学习

- 机器学习平台 PAI特征

- 机器学习平台 PAI实践